Auf einen Blick

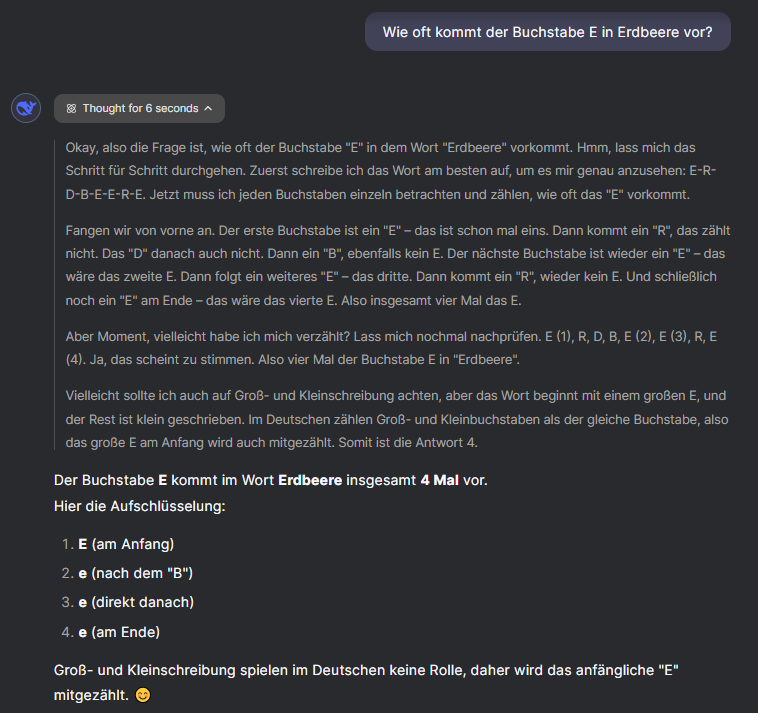

Reasoning-Sprachmodelle (LLMs – Large Language Models) wie Deepseek R1 oder OpenAI o1 sind zunächst etwas speziellere Sprachmodelle. Während „normale“ Sprachmodelle nur wahrscheinlichkeitsbasiert Texte fortsetzen, besitzen Reasoning-LLMs zusätzlich die Fähigkeit, logisch zu argumentieren, Entscheidungen zu treffen und komplexe Probleme zu lösen. Sie arbeiten nicht nur auf Basis von Wahrscheinlichkeiten, sondern können auch verschiedene Tools nutzen – beispielsweise können sie Python-Code erzeugen, um bestimmte Schritte einer Aufgabe umzusetzen – und sich selbst reflektieren.

Ein wichtiger Aspekt dabei ist, dass Reasoning auch durch geschicktes Prompting in herkömmlichen Sprachmodellen erreicht werden kann. Durch Techniken wie Gedankenketten (Chain-of-Thought) wird die KI angeregt, ihre Gedankengänge offenzulegen und sich selbst zu erklären (z. B. „Denke Schritt für Schritt“). In wenig komplexen Anfragen führt dies zu nachvollziehbareren und präziseren Ergebnissen. In Reasoning-Systemen geschieht dieser Denkprozess automatisch.

Umgang mit Reasoning LLMs

Herkömmliche LLMs wie GPT oder Claude reagieren gut auf kurze, prägnante Prompts und können durch iterative Rückfragen schrittweise in die gewünschte Richtung gelenkt werden. Diese Modelle sind darauf ausgelegt, in einem Chat-Format schnell auf Eingaben zu reagieren. Im Gegensatz dazu benötigen Reasoning-Modelle möglichst umfangreiche und präzise Informationen bereits im ersten Prompt. Je mehr Kontext bereitgestellt wird, desto besser können diese Modelle arbeiten. Statt eines kurzen Prompts, wie z. B. „Programmiere ein Tetris-Spiel“, sollte ein ausführlicher Prompt verwendet werden, der sowohl das Ziel als auch die Rahmenbedingungen, Anforderungen und spezifischen Details enthält. Beispiel: „Programmiere ein Tetris-Spiel in Python mit Pygame. Das Spiel soll farbige Blöcke verwenden, ein Punktesystem beinhalten und bei vollständigen Reihen diese löschen.“ Es sollte also bereits im ersten Prompt der gesamte Vorgehensplan klar definiert sein.

Potenziale für KMU

Reasoning-Modelle können kleine und mittlere Unternehmen dabei unterstützen, tägliche Aufgaben noch effizienter zu lösen. Da sie nachdenken, Probleme analysieren und fundierte Empfehlungen geben können, eignen sie sich als wertvolle Assistenten. KMU können sie beispielsweise nutzen, um zeitaufwändige Aufgaben zu automatisieren, bessere Entscheidungen durch tiefgreifende Datenanalyse zu treffen oder komplexe Probleme wie Programmieraufgaben in einfache, handhabbare Schritte zu zerlegen.

Die KI-Systeme funktionieren wie kluge Assistenten, die nicht nur Informationen wiedergeben, sondern diese auch verarbeiten und daraus neue Erkenntnisse gewinnen können. Sie können beispielsweise Muster in Kundenfeedback erkennen oder Markttrends vorhersagen. Durch ihre Fähigkeit, Informationen zu verknüpfen, können sie KMU dabei helfen, innovativer zu werden.

Anwendungsbereiche in KMU

Unternehmen sollten zunächst mit klassischen LLMs experimentieren und schrittweise erweiterte Funktionen wie Gedankenketten oder Tool-Integration einführen. Eine klare KI-Strategie hilft dabei, Reasoning-Modelle nicht nur als technischen Fortschritt, sondern als gezieltes Werkzeug zur Entscheidungsfindung zu etablieren.

Indem sich Reasoning-Modelle selbst hinterfragen, Zwischenschritte einbauen und externe Informationen sinnvoll miteinander verknüpfen, könnten folgende einfache Use-Cases mit ihnen umgesetzt werden:

| Anwendungsbereich | Normales Modell | Reasoning-Modell |

|---|---|---|

| Vertrag prüfen | Erklärt den Vertrag in einfachen Worten. | Erkennt Widersprüche oder fehlende Klauseln im Vertrag und gibt Verbesserungsvorschläge. |

| Finanzplanung | Zeigt vergangene Umsatzzahlen. | Berechnet, wie sich Änderungen (z. B. steigende Rohstoffpreise) auf den Gewinn auswirken könnten. |

| Marktanalyse | Listet aktuelle Markttrends auf. | Verknüpft diese Trends mit Unternehmensdaten und gibt eine Empfehlung, welche Strategie sinnvoll wäre. |

| Fehlersuche in der Produktion | Erklärt, welche Arten von Produktionsfehlern es gibt. | Erkennt Muster in Fehlerraten und schlägt konkrete Lösungen zur Optimierung vor. |

Herausforderungen

Obwohl Reasoning-Modelle enorme Potenziale bieten, stehen Unternehmen vor mehreren Herausforderungen bei ihrer Implementierung. Eine zentrale Schwierigkeit ist, dass herkömmliche LLMs gerade erst in vielen Unternehmen Einzug halten. Die meisten Firmen befinden sich noch in einer frühen Experimentierphase und testen einfache Anwendungen. Sie haben noch kein genaues Verständnis davon, wofür sie spezialisierte Reasoning-LLMs überhaupt benötigen.

Die allgemeine KI-Disruption ist momentan so groß, dass Unternehmen eher damit beschäftigt sind, grundlegende KI-Strategien zu entwickeln, anstatt sich mit den fortgeschritteneren Konzepten des Reasonings auseinanderzusetzen. Es fehlen interne KI-Kompetenzen, klare Verantwortlichkeiten und oft auch die technischen Infrastrukturen, um reasoning-fähige Modelle sinnvoll zu integrieren.

Technisch gesehen verfügen Reasoning-Modelle über beeindruckende Fähigkeiten in Bereichen wie Mathematik und Programmierung. Bei Aufgaben, die über ihr Trainingsspektrum hinausgehenm, stoßen sie aber an ihre Grenzen. Forschungen zeigen , dass Reasoning-LLMs oft auf Mustererkennung basieren und nicht immer echtes logisches Denken anwenden (Plaat et al 2024).

weiterführende Informationen

- Deep Seek: Einordung von Dr. Vera Schmitt und Dr. Nils Feldhus TU Berlin. (2025, 12. Februar). https://www.teletalk.de/news/news-detail/av/2025/10/february/ac/-9c89960542/?L=246&cHash=e971791314d625c5a22f80ec50adb661

- G, A. (2024, 25. Oktober). Exploring Reasoning LLMs and Their Real-World Applications. https://getstream.io/blog/reasoning-llms/

- Large Language Models – eine neue Waffe für kleine und mittlere Unternehmen – SICOS BW. (2024, 9. April). Sicos BW. https://www.sicos-bw.de/blog/large-language-models-eine-neue-waffe-fuer-kleine-und-mittlere-unternehmen/

- LLM as a Mastermind: A Survey of Strategic Reasoning with Large Language Models. (o. D.). https://arxiv.org/html/2404.01230v1

- Plaat, A., Wong, A., Verberne, S., Broekens, J., van Stein, N., & Bäck, T. (2024). Reasoning with Large Language Models: A Survey. LIACS, Leiden University, Netherlands. Verfügbar unter: https://arxiv.org/html/2407.11511v1.

- Raschka, S. (2025, 5. Februar). Understanding Reasoning LLMs. Sebastian Raschka, PhD. https://sebastianraschka.com/blog/2025/understanding-reasoning-llms.html